Eine der Hauptverteidigungen derjenigen, die sich als Kunstgeneratoren mit KI auszeichnen, besteht darin, dass, obwohl die Modelle auf vorhandenen Bildern trainiert werden, alles, was sie erstellen, neu ist. Missionare der künstlichen Intelligenz oft Vergleichen Sie diese Systeme mit echten Künstlern. Die Schöpfer lassen sich von all denen inspirieren, die vor ihnen kamen, also warum nicht die KI ähnlich der vorherigen Arbeit gestalten?

Die neue Forschung könnte dieses Argument zunichte machen, und es könnte sogar zu einem großen Knackpunkt werden Mehrere laufende Gerichtsverfahren im Zusammenhang mit KI-generierten Inhalten und Urheberrechten. Forscher aus Industrie und Wissenschaft haben herausgefunden, dass die beliebtesten und kommenden KI-Bildgeneratoren Bilder aus den Daten „speichern“ können, mit denen sie trainiert wurden. Anstatt etwas völlig Neues zu erstellen, lässt die KI bei einigen Eingabeaufforderungen einfach ein Bild reproduzieren. Einige dieser nachgebildeten Bilder können urheberrechtlich geschützt sein. Aber noch schlimmer, moderne generative KI-Modelle haben die Fähigkeit, sensible Informationen zu speichern und zu reproduzieren, die zur Verwendung in einem KI-Trainingsset gesammelt wurden.

studieren Geleitet von Technikforschern – um genau zu sein Das Google und DeepMind – und an Universitäten wie Berkeley und Princeton. Die gleiche Crew arbeitete weiter vorheriges Studium die ein ähnliches Problem mit KI-Sprachmodellen identifizierten, insbesondere GPT2, Einführung in OpenAI-Modelle ChatGPT ist sehr beliebt. Als die Band wieder zusammengebracht wurde, stellten Forscher unter der Leitung des Google Brain-Forschers Nicholas Carlini fest, dass sowohl Googles Imagen als auch das beliebte Open-Source-Programm Stable Diffusion in der Lage waren, die Bilder zu reproduzieren, von denen einige offensichtliche urheberrechtliche oder lizenzrechtliche Auswirkungen auf die Bilder hatten.

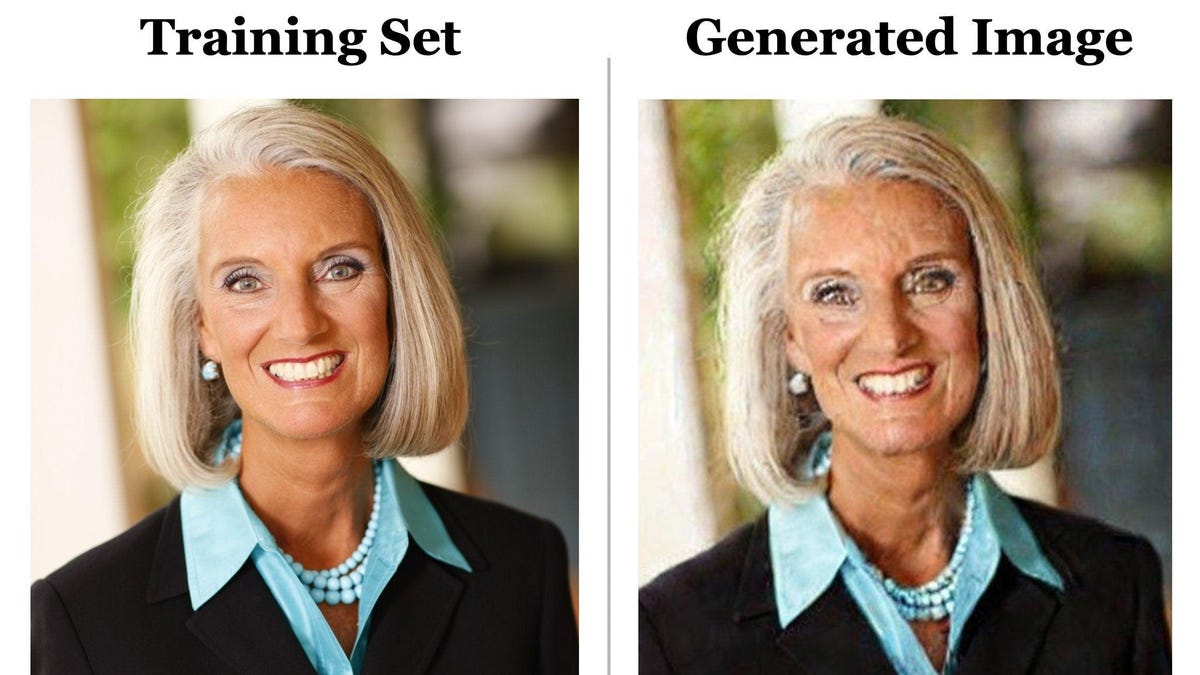

Das erste Bild in diesem Tweet wurde unter Verwendung der Bildunterschrift erstellt, die im Stable Diffusion-Datensatz enthalten ist, der fragmentierten Multi-Terabyte-Bilddatenbank namens LAION. Das Team fütterte die Bildunterschrift in die Eingabeaufforderung „Stable Diffusion“ ein, und sie kamen mit genau demselben Bild heraus, wenn auch leicht verzerrt durch digitales Rauschen. Der Prozess, diese doppelten Fotos zu finden, war relativ einfach. Das Team führte dieselbe Eingabeaufforderung mehrmals aus, und nachdem die Forscher dasselbe Ergebnisbild erhalten hatten, überprüften sie manuell, ob das Bild im Trainingssatz vorhanden war.

G/O Media kann eine Provision verdienen

Zwei der Forscher auf dem Papier, Eric Wallace, ein Doktorand an der UC Berkeley, und Vikash Siwag, ein Doktorand an der Princeton University, sagten Gizmodo in einem Zoom-Interview, dass die Bildreplikation selten ist. Ihr Team probierte etwa 300.000 verschiedene Untertitel aus und fand eine Auswendiglernquote von nur 0,3 %. Doppelte Bilder waren viel seltener bei Modellen wie Stable Diffusion, die Bilder in ihrem Trainingssatz deduplizierten, obwohl am Ende alle Diffusionsmodelle mehr oder weniger das gleiche Problem haben werden. Die Forscher fanden heraus, dass Imagen durchaus in der Lage war, Bilder zu speichern, die nur einmal im Datensatz vorhanden waren.

„Die Einschränkung hier ist, dass das Modell verallgemeinern soll und neue Bilder erzeugen soll, anstatt eine im Gedächtnis gespeicherte Kopie auszuspucken“, sagte Sehwag.

Ihre Forschung zeigt, dass mit zunehmender Größe und Komplexität von KI-Systemen die Wahrscheinlichkeit steigt, dass KI repliziertes Material produziert. Ein kleineres Modell wie Stable Diffusion hat einfach nicht die gleiche Menge an Speicherplatz, um die meisten Trainingsdaten zu speichern. das In den nächsten Jahren könnte sich viel ändern.

„Vielleicht nächstes Jahr, egal welches neue Modell herauskommt, das viel größer und viel leistungsstärker ist, diese Arten von Naturschutzrisiken werden wahrscheinlich viel größer sein als jetzt“, sagte Wallace.

Durch einen komplexen Prozess, bei dem die Trainingsdaten mit Rauschen zerstört werden, bevor die gleiche Verformung entfernt wird, erzeugen diffusionsbasierte maschinelle Lernmodelle Daten – in diesem Fall Bilder – ähnlich dem, was darauf trainiert wurde. Diffusionsmodelle waren eine Weiterentwicklung von generativen gegnerischen Netzwerken oder GAN-basiertem maschinellem Lernen.

Die Forscher fanden heraus, dass GAN-basierte Modelle nicht das gleiche Problem beim Speichern von Bildern haben, aber es ist unwahrscheinlich, dass große Unternehmen über die Diffusion hinausgehen, es sei denn, es entsteht ein ausgeklügelteres maschinelles Lernmodell, das realistischere, qualitativ hochwertigere Bilder erzeugt.

Florian Trammer, Professor für Informatik an der ETH Zürich, der an der Forschung beteiligt war, stellte fest, wie viele KI-Unternehmen Benutzern raten, ob in kostenlosen oder kostenpflichtigen Versionen, eine Lizenz zum Teilen oder sogar zur Monetarisierung von KI-generierten Inhalten zu erteilen. Die KI-Unternehmen selbst behalten sich auch einige Rechte an diesen Bildern vor. Dies könnte ein Problem sein, wenn die KI ein Bild erstellt, das genau dem bestehenden Urheberrecht entspricht.

Mit einer Sparquote von nur 0,3 % können sich KI-Entwickler diese Studie ansehen und feststellen, dass das Risiko nicht allzu groß ist. Unternehmen können daran arbeiten, Bildduplikate in Trainingsdaten zu entfernen, wodurch die Wahrscheinlichkeit einer Speicherung verringert wird. Verdammt, sie könnten sogar KI-Systeme entwickeln, die erkennen, ob ein Bild ein direktes Duplikat eines Bildes in den Trainingsdaten ist, und es zum Löschen markieren. Es verbirgt jedoch das volle Datenschutzrisiko, das von der generativen KI ausgeht. Auch Carlini und Trammer halfen mit Ein weiteres aktuelles Papier Wobei ich argumentierte, dass selbst Versuche, die Daten zu filtern, immer noch nicht verhinderten, dass die Trainingsdaten durch das Modell sickerten.

Und natürlich besteht die große Gefahr, dass Bilder auf den Bildschirmen der Benutzer erscheinen, die niemand reproduzieren möchte. Wallace fragte, ob der Forscher zum Beispiel einen vollständigen Satz synthetischer medizinischer Daten für Röntgenaufnahmen von Menschen erstellen wolle. Was soll passieren, wenn künstliche Intelligenz auf Basis von Diffusion gerettet wird Und die tatsächlichen Krankenakten einer Person duplizieren?

„Das kommt sehr selten vor, also merkt man es vielleicht zunächst nicht, und dann kann man diesen Datensatz tatsächlich im Internet veröffentlichen“, sagte der Student der UC Berkeley. „Das Ziel dieser Arbeit ist es, potenziellen Fehlern, die Menschen machen könnten, einen Schritt voraus zu sein.“

„Kaffee-Wegbereiter. Leidenschaftlicher Twitter-Freak. Allgemeiner Web-Evangelist. Musikkenner.“

More Stories

Warum spielten Alec Baldwin und Geena Davis nicht die Hauptrollen in Beetlejuice 2?

„Swifties for Kamala“ sammelt fast 140.000 US-Dollar für Harris | Taylor Swift

Carole King und Elizabeth Warren schließen sich der Kampagne „Swifties for Kamala“ an: „Als alleinstehende Katzendamen … sind wir Teil dieser Kampagne“